Pythonモジュール「BeautifulSoup」でWebスクレイピングでTable(表)のデータをCSVに保存する方法についてまとめました。

【例1】単純な表(Table)をCSVに変換(BeautifulSoup)

Pythonモジュール「BeautifulSoup」でWebスクレイピングでTable(表)のデータをCSVに保存します。

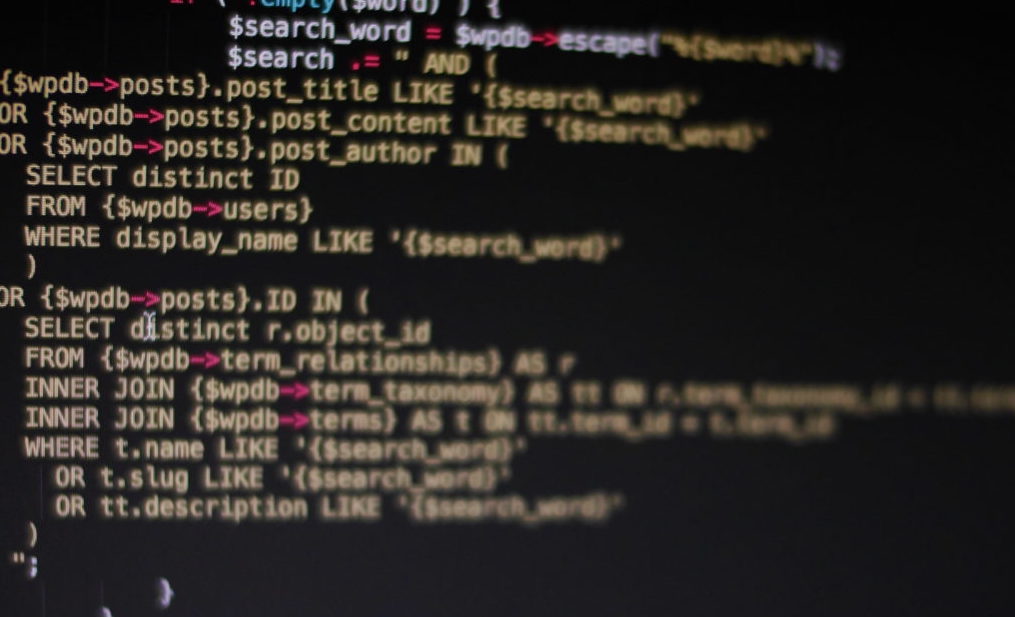

【サンプルコード】

サンプルプログラムのソースコードです。

【対象のHTMLファイル】

【出力ファイル sample03.csv】

【Python】Webスクレイピング入門(BeautifulSoup4編)

Pythonモジュール「BeautifulSoup4」を用いたWebスクレイピングについて入門者向けにまとめました。

コメント